Pourquoi mettre en place un fichier robots.txt dans votre site

Les moteurs de recherche naviguent sur vos blogs et sites à la recherche de contenus à indexer. Malheureusement ces robots sont un peu gourmands et prennent donc tout ce qu’ils trouvent lors de leur exploration. Afin de les aider dans leur quête il est recommandé de mettre un petit fichier texte à la racine de votre blog afin de donner des directives sur la manière d’explorer votre site avec des go no go en fonction des dossiers ou types de fichiers.

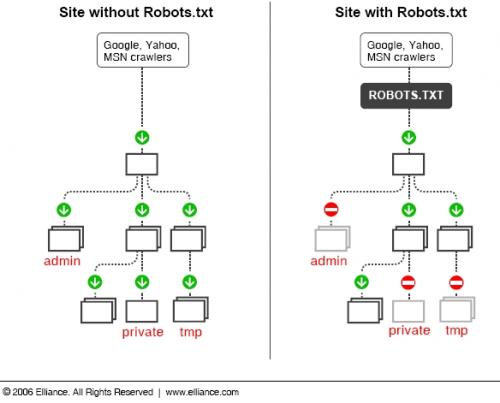

Voici une illustration de l’intérêt d’un fichier robots.txt :

Sitemap: http://www.vingthuitzerotrois.fr/wp-sitemap.php

User-agent: *

Disallow: /wp-content/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-

Disallow: /feed/

Disallow: /trackback/

Disallow: /cgi-bin/

Disallow: /addons/

Disallow: /test/

Allow: /wp-sitemap.php

User-agent: Googlebot

Disallow: /*.php$

Disallow: /*.js$

Disallow: /*.cgi$

Disallow: /*.xhtml$

Disallow: /*.php*

Disallow: */trackback*

Disallow: /*?*

Disallow: /z/

Disallow: /wp-*

Disallow: /*.inc$

Disallow: /*.css$

Disallow: /*.txt$

Allow: /wp-content/uploads/

Allow: /wp-sitemap.php

User-agent: Googlebot-Image

Allow: /*

24 commentaires sur “Pourquoi mettre en place un fichier robots.txt dans votre site”

Les commentaires sont fermés.

L’utilisation d’un fichier Robots.txt adapté permet aussi d’éviter de voir d’éventuelles failles de sécurité affichées en première page de Google.

Certains hackers se contentent de taper des requêtes spéciales dans les moteurs de recherche pour scanner les failles des sites webs.

Bloquer l’accès des crawlers à certains répertoires sensibles (par exemple le répertoire wp-includes de WordPress) ne soignera pas le problème mais cela le rendra au moins beaucoup plus discret, vous laissant le temp d’agir.

Très bonne remarque Romain

il me semblait qu’en raison de la guerre à l’indexation, les robots de google et yahoo indexent tout ce qu’ils trouvent, le robots.txt ne servant alors qu’à interdire l’affichage du resultats dans le moteur de recherche.

bel article, j’avais mis en place un sitemap, je vais regader su côté du robots.txt

Lien effacé car hors sujet

Lump[YaNa] si tu veux te faire blacklister ton IP sur 2803 continues comme cela tu n’en es pas loin du tout…

Ouais, ben j’ai mis un robots.txt à la racine de mon domaine depuis près d’un mois et Google continue d’indexer ma page de contact, mon flux et le flux des commentaires, etc…

J’ai pourtant soumis ce fichier à google webmastertools sans problème, mais bon…

Donc merci pour cet article mais je me demande toujours à quoi ça sert :s

Il faut attendre un peu avant de voir disparaitre du moteur le contenu déjà indexés par google…

J’ai une question : ma sitemap est en xml (générée par plugin). Comment faire pour avoir une sitemap en wp-sitemap.php, comme ici ?

Dans cet article : http://docs.abondance.com/robots.html, certaines des informations que vous donnez sont contredites (l’utilisation de l’étoile * et la commande Allow).

Après une petite recherche, il apparaît que la commande Allow est peu prise en charge, et que l’étoile n’est utilisable que dans le champ « User-agent »…

Note que le standard du robots.txt ne permet pas de faire des filtres avec un « wildchar » dans les chemins. Cependant, certains robots les acceptent. Certains services d’indexation permettent de vérifier la validité de son fichier robots.txt, avec éventuellement le confronter à une batterie d’URLs de test.

Le service Google Sitemaps permet notamment de faire ce genre de vérifications. Il serait en effet de faire un robots.txt qui ne soit pas correctement interprété par les robots d’indexation et qui, pire, serait ignoré, du fait d’une mauvaise syntaxe.

Certains points en matière de robots.txt sont tout de même à noter : s’il est de bon ton d’interdire l’indexation de certaines parties sensibles d’un site web aux robots d’indexation des moteurs de recherche, les hackers ayant tendance à faire des requêtes du type « inurl:admin.php » pour identifier des cibles potentielles prêtes à être hackées par l’exploitation de failles de sécurité des divers outils de publication web, il est en revanche important de noter que la lecture du robots.txt peut être faite par n’importe qui, et en particulier par des robots d’indexation, dont des robots de hackers. Aussi, il est très important de ne pas y faire figurer de dossiers « confidentiels », et de bien veiller à protéger ceux-ci via un mot de passe, notamment via un mot de passe au niveau du serveur web.

@epikurieu en ce qui concerne la fonction Allow je peux valider qu’elle fonctionne car elle autorise mon sitemap.php qui sans ce « allow » ne fonctionnait pas dans le webmastertool de google… Pour les wildcards il semble que cela fonctionne aussi mais il faut faire des test pour vérifier qu’ils marchent chez toi.

La stratégie pour robots.txt

* Déclarer les pages *publiques* que l’on veut interdire à l’accès des indexeurs.

* Ne pas déclarer les pages d’admins, et autres. Car pour le coup, cela les rend vraiment visibles à tous. Pour les pages d’admins, il est préférable de mettre en place un .htaccess avec un mot de passe et un login.

Voici un autre article sur le même sujet paru dans selfhtml

http://fr.selfhtml.org/divers/robots.htm

Bonjour,

Je suis en train de faire mon fichier robots.txt et je me demandais quoi inclure dedans. Alors, si je comprends bien le tout, je dois pas y inclure les dossiers des includes php, des css, des librairies javascript et dossier d aministration du cms?

Dans le cas où j ai une commande serveur qui restreind l acces aux contenus des dossiers de mon site sans urls complètes, est-ce que les robots peuvent y accéder quand meme?

Merci

Alex

I have visited your site 835-times

Your site found in Google: position651

Your site found in Google: http://google.com/search?q=qxl

I could not find this site in the Search Engines index

Merci pour ce super article.

Je me demandais s’il était judicieux d’interdire aux moteurs d’accéder aux pages de tags.

Si oui, ça ressemblerait à ça non? disallow: /tag

Merci beaucoup si tu trouves le temps de répondre.

Garry

Je mettrai un / à la fin mais cela a l’air bon!

Merci beaucoup!

y a-t-il une différence entre un sitemap en php et xml?

Bonjour,

Je prépare un site qui sortira cette semaine. Je suis totalement débutante dans tout ce qui touche le SEO.

Votre article est interessante mais j’avoue que je suis nulle de ne pas tout comprendre. Vous et d’autres sites conseillez de mettre le Dissalow sur Wp-content. Mais mon contenu se trouve tous dans ce répertoire wp-content/themes/nom du theme/… Si on dit au robot de ne pas y aller comment fait-on alors pour que mon contenu soit référencé. Car tout ce qui affiche sur le net vient de ces répertoires non ? A moins que je confonds vraiment tout et je vous prie de m’excuser dans ce cas là.

Merci pour votre aide :)