Crise d’obésité pour les pages internet?

Voila le sujet n’est pas nouveau mais avec l’augmentation des bandes passantes, la baisse des couts d’hébergement et l’intégration de technologies comme l’ajax, le flash… et bien les pages des sites internet grossissent à vue d’oeil.

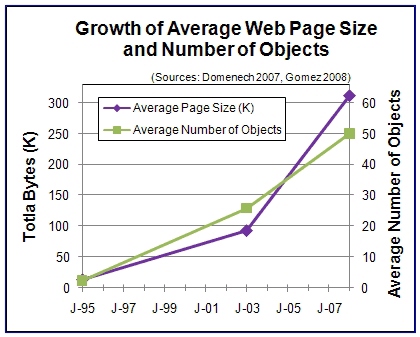

Rappelez vous en 1995, une page Internet devait pesez à tout casser quelques kb parce qu’avec plus elle n’était pas consultable… Mais depuis 1995, l’obésité des pages internet semble progresser drastiquement avec une augmentation quasi constante du poids comme le présente le graphique ci-dessous :18 commentaires sur “Crise d’obésité pour les pages internet?”

Les commentaires sont fermés.

Je n’ose pas imaginer le poids de certaines applications Facebook…

Et moi avec mon logo qui fait à lui seul 67ko …

Me rappelle d’une époque où on prenait comme référence la page d’accueil de Yahoo et ses 40 ko. Maintenant la home de yahoo pèse plus de 500 ko mais peut on vraiment comparer les sites ? Il n’y a qu’à voir la masse d’information présente sur une page désormais. Finalement il n’y a bien que Google qui maitrise son poids

Google = anorexique même !

Effectivement les possibilités qu’offre le multimédia fait augmenter les kilos octets.

Mais ne pourrait-on pas prendre le raisonnement inverse ? Au lieu de parler d’obésité, ne peut-on pas imaginer qu’en 1995 le web vivait d’une anorexie forcée due à la limitation des capacités techniques. C’est un peu comme si en 1995 il y avait uniquement des pulls de taille S et que nous devions tous faire un régime afin de s’habiller.

Il faudrait mettre en face la vitesse moyenne de connexion des Internautes. En 1995, en France, on faisait au mieux du 33,6 Kbps, alors qu’en 2008, on fait au mieux du 20 Mbps, à savoir qu’on surfe jusqu’à 600 fois plus vite…

Oui cette évolution du poids des sites webs est tout à fait normale et prévisible. Les technologies, les infrastructures permettant de supporter un meilleur débit, forcément pourquoi s’en priver ? Ainsi les sites utilisent à outrance (parfois trop) ce débit important.

La où le débat prend un tout autre sens c’est quand on parle de la saturation qui finira par arriver, des réseaux. Avec tout ces sites, notamment de streaming audio/vidéo, la demande en bande passante se fait de plus en plus importante… les couts aussi.

Tiens, en fait, j’ai sousestimé la capacité de surf maximale en me limitant à tort à l’ADSL : avec le câble, on peut monter à 100 Mbps, et ça ne touche pas uniquement quelques centaines d’immeubles parisiens (les offres en FTTH de Free et FTTB d’Orange), mais quelques millions de foyers en France (les offres d’Internet par câble très haut débit de Numéricâble). C’est juste que très peu de personnes ont franchi le pas (ça coûte tout de même assez cher, de l’ordre de 70 à 90 € TTC l’offre triple-play en 100 Mbps chez Numéricâble).

Bref, les offres de haut débit les plus faibles actuellement rencontrées sur le marché français sont de 512 Kbps, alors que les plus rapides ontent à 100 Mbps. Bref, je n’ai pas l’impression que cette « obésité » soit particulièrement gênante, sinon pour les quelques villageois perdus au fin fond de la France qui refusent de migrer en ville et ne peuvent par conséquent qu’exploiter des connexions modem à 56 Kbps ou Numeris à 128 Kbps.

Une tendance avec 3 points, c’est osé… Si tu vas revoir les autres graphes qui sont présentés dans ta source, tu verras :

1) que la tendance se tasse (pour les 1000 sites les plus visités)

2) que le temps de chargement de ces pages reste stable voire s’améliore (merci la BP)

La seule vraie conclusion, c’est que les gens qui habitent loin de leur DSLAM, voire qui n’en ont pas se voient fermer la porte de l’Internet. Mais n’est-ce pas aussi le cas des mal-voyants qui voient disparaître de plus en plus d’éléments sur les sites Web, au fur et à mesure que le flash étend sa présence ?

j’ajouterai que venant d’un site sur l’optimisation Web, les conclusions sonpê trompeuses…

C’est certain que l’ADSL et bientôt la fibre optique sont des facilitateurs pour les sites qui proposent des contenus riches et lourds. Même si la bande passante disponible augmente, il est indéniable que le poids des pages augmentent au fil des années, en 10 ans on constate un facteur 10 pour simplifier le graphique. Le temps de réponse des sites sont quant à eux plus rapide….

Parfois en vacances je suis obligé de me connecter en 56kb/s et la navigation est laborieuse quelque soit le site…

@henri, il est clair que les sites web ne sont plus faits pour être exploités avec un simple modem 56 Kbps, même si près de 10 % de la population française utilise ce type de connexion pour surfer. Il faut dire que la plupart des sites visent les citadins qui ont un accès haut débit, et un public de préférence à haut revenu, avec un goût prononcé pour la haute technologie, bref, le public des first adopters.

Cependant, avec la diversité des types d’accès, et je pense notamment aux smartphones, ou encore aux consoles de jeux portables et de salon, et des accès WiFi publics et autres réseaux 3G et 3G+ qui se développent, bien que lentement, il deviendra peut-être intéressant, à l’avenir, de limiter la taille des données échangées entre le site et ses visiteurs.

Ceci étant, dans le cas de ton site, par exemple, s’il rame à charger depuis la France, ce n’est pas tant du fait de son poids (environ 227 Ko pour la présente page), ni de la quantité de requêtes (49 pour la présente page), mais plutôt de son éloignement géographique (Canada, alors que la plupart de tes visiteurs viennent probablement de France), de la diversité des hôtes d’où proviennent les fichiers chargés (tu as vraiment besoin des cinq ou six scripts différents pour suivre tes stats de fréquentation, chacun sur un hôte distinct ?), ou encore de la quantité de scripts chargés, dont le chargement n’est pas parallélisé (et le script d’édition des commentaires semble le plus lourd à charger).

C’est vrai que j’ai bcp de script de stat il faut que je fasse un peu le ménage ;) Théoriquement la fonction de cache est bien active sur le serveur donc cela aide un peu pour le téléchargement des images et des trucs cachables! Je vais virer le plugin d’édition des commentaires il rame un peu en ce moment ;)

Ca tombe bien, les connections internet ont leur débit plutôt sacrément multiplié depuis 95, l’âge d’or du 33k :) (et encore, j’ai un doute)

Il faudrait arrêter de croire que tout le monde est en haut débit à minimum 20 Mo ! Déjà moi qui suit bien équipé avec une FreeBox HD, je ne suis qu’à 3 Mo parce que loin du DSLAM, alors que j’habite pourtant en région parisienne. Alors en province mal desservie je vous laisse imaginer, et je ne vous parle pas des DOM/TOM qui sont encore pour certains en RTC 56k !

Sinon, quel rapport entre Ajax et poids des pages ???

Vous pourrez dire à Raymond Domenech que ça s’écrit comme ça : « TOTAL » et pas « TOTLA ».

Concernant le poids des pages, est-ce que les blogs peuvent raisonnablement se tenir à des pages de moins de 50 ou 100ko ? Je ne crois pas. Avec des dizaines de commentaires, des publicités, une belle en-tête graphique, les meta (tags, catégories, liens divers), les pages tendent réellement à s’allonger et donc à s’alourdir …

C’est parfois dommage, parce que je suis en 6Mo partagé sur 20PC, alors ça rame bien souvent …

C’est clair, au début ma charte avait systématiquement un petit visuel pour illustrer le résumé du billet. Un bidule de 90px x 90px. Trois fois rien, mais depuis que j’affiche une quarantaine de billets en home, je n’en mets plus tout le temps parce que ça finit pas faire plus de 100 ko juste pour afficher des vignettes. Maintenant, j’en mets quand j’ai le temps et selon l’inspiration. du coup, j’ai énormément gagné.

Dans la notion de poids il y a deux concepts : le premier est lié à la bande passante, c’est-à-dire au temps que met une page web à faire le chemin du serveur vers le navigateur, et le deuxième est lié au traitement de cette même page par le navigateur.

En gros, une page peut être lourde mais s’afficher rapidement si elle possède une structure html saine, ou être plus légère, mais nécessiter des temps de traitement plus long de la part du navigateur.

Je m’en suis réellement aperçu lorsque j’ai du utiliser ma connexion RTC de secours pendant un mois ;)

J’en ai marre de c’est pages trop lourdes, je suis en 3G (environ 3 Mo) illimitté mais limité quand même a 1Go par mois, aprés le débit passe a environ 150 Ko, donc avec ces pages lourdes au bout de 1 semaine je suis en bat débit donc soit; ont diminuent les pages, soit ont augmentent le débit mais ça risque de saturé a la longue…