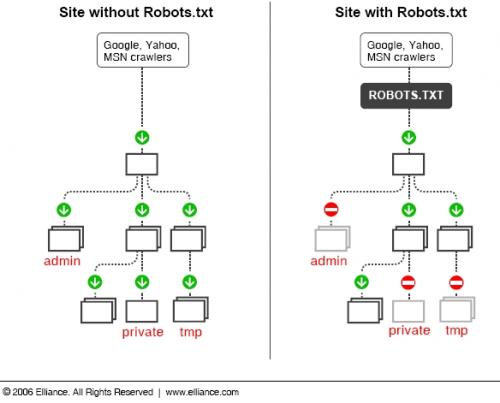

Les moteurs de recherche naviguent sur vos blogs et sites à la recherche de contenus à indexer. Malheureusement ces robots sont un peu gourmands et prennent donc tout ce qu’ils trouvent lors de leur exploration. Afin de les aider dans leur quête il est recommandé de mettre un petit fichier texte à la racine de votre blog afin de donner des directives sur la manière d’explorer votre site avec des go no go en fonction des dossiers ou types de fichiers.

Voici une illustration de l’intérêt d’un fichier robots.txt :

Avant de rentrer dans le vif du sujet il faut obligatoirement placer le fichier robots.txt à la racine de votre blog ou site. Mettre ce fichier dans le dossier « blog » si votre adresse est http://www.mondomaine.com/blog ne sert à rien il faut le mettre dans le dossier racine. En revanche si vous avez des sous-domaines il est possible de mettre en place un robots.txt par sous-domaine (ce que j’ai fait pour les blogs 2803).

Alors quoi mettre dans ce fichier robots.txt? Plutôt que des longs discours voici le fichier robots.txt de 2803 :

Sitemap: http://www.vingthuitzerotrois.fr/wp-sitemap.phpUser-agent: *

Disallow: /wp-content/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-

Disallow: /feed/

Disallow: /trackback/

Disallow: /cgi-bin/

Disallow: /addons/

Disallow: /test/

Allow: /wp-sitemap.phpUser-agent: Googlebot

Disallow: /*.php$

Disallow: /*.js$

Disallow: /*.cgi$

Disallow: /*.xhtml$

Disallow: /*.php*

Disallow: */trackback*

Disallow: /*?*

Disallow: /z/

Disallow: /wp-*

Disallow: /*.inc$

Disallow: /*.css$

Disallow: /*.txt$

Allow: /wp-content/uploads/

Allow: /wp-sitemap.phpUser-agent: Googlebot-Image

Allow: /*

Voici quelques explications sur ce fichier txt vraiment important.

Notez que j’utilise plusieurs directives en fonction des « User-agent » (* pour tous les robots des moteurs de recherche, googlebot pour le robots de google, et Googlebot-Image pour le robots d’images de google).

La commande « Disallow » me permet d’interdire l’indexation d’un dossier ou d’une URL intégrant le chemin interdit.

A l’inverse la commande « Allow » autorise et vient en contradiction avec la « Disallow ». Par exemple si l’on a interdit une extension de fichier .php pour mon cas d’où un « Allow: /wp-sitemap.php ».

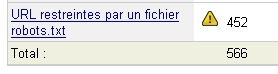

Pour le Googlebot mes restrictions sont encore plus importantes puisque j’interdis tout simplement l’indexation de fichiers dont l’extension se termine par php, js, xhtml, css… Cela permet de faire le ménage dans l’index de google et de diminuer sensiblement le « duplicate content« . En effet, en faisant cela j’interdis l’indexation du fichier index.php qui s’apparente à du « duplicate content » par rapport au nom de domaine sans index.php et qui affiche la même chose.

Bien entendu ce robots.txt est à adapter au cas par cas en fonction de la plateforme de blog et des dossiers à interdire ou non. Pour tester son fichier et pour valider que vous n’avez pas fait d’erreurs il est possible de le tester ici (bien pratique comme outil d’ailleurs).